在做节点下线的时候,发现开始很快,后面就不动了,查看日志也没有异常,只是在进行复制。

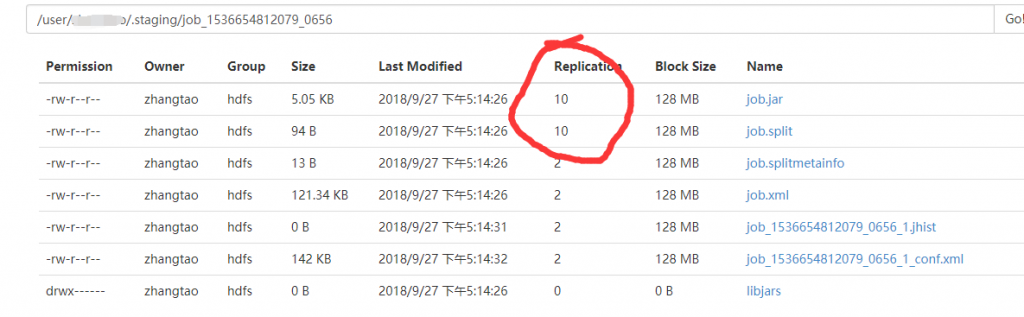

发现是有部分文件复制因子居然是10,果断删除了。

先通过命令查看那些数据在需要删除的节点

# hadoop fsck / -blocks -locations -files

通过hadoop自带的文件浏览器也能发现,这些文件居然需要10个副本,此文件目录hadoop yarm 任务程序缓存目录,可以删除,删除后会自动创建。

发现部分数据有10份。在用户目录/user/[username]/.staging/ 下面

然后果断删除了,

# hadoop dfs -rmr /user/[username]/.staging/*

并且删除回收站里面的

# hadoop dfs -rmr /user/[username]/.Trash/Current/*

hadoop datanode 下线 Decommission in progress 到 Decommissioned 时间太长了